これは激動の時代の始まりであり、私たちは常に革新を受け入れ続けなければなりません。しかし、一つ確かなことは、ジャーナリストにその仕事に対して適切な報酬を支払わないと、長期的には非常に危険な人工知能の外部性を生み出すことになるということです。 Appunti di Stefano Feltri ニュースレターの Nello Cristianini の記事

ニューヨーク・タイムズがChatGptを運営するOpenAiに対して起こした訴訟は、著作権だけでなく、今後数年間に人工知能とどのように共存できるかについても争われている。

近い将来、既存のリソースを活用して新しい市場を征服することが可能になった場合、長期的には同じリソースはどうなるでしょうか?

私たちは人間、この場合はジャーナリストによって作成された高品質のコンテンツについて話しています。

ニューヨーク・タイムズは、OpenAIとその最初の投資家であるマイクロソフトを訴え、ChatGptのトレーニングに同紙の記事を利用する(とされる)行為を中止するか、その使用に対して十分な補償をするよう求めている。

これは出版社、活動家、クリエイターらが起こした一連の訴訟の最新のもので、利害の異なる2つの業界間の長い戦いの始まりにすぎない。

また、この新しいテクノロジーである生成人工知能のコストと利点を、プラスの外部性とマイナスの外部性の観点から考える機会でもあります。

すべての基礎には、新しい技術的現実があります。それは、「コンテンツ」、つまり人間の使用を目的とした情報を理解し、生成する新しい知的なエージェントの能力であり、この能力は近年になってようやく出現したものであり、法制度はそれをサポートしていません。まだ準備ができています。

これらの新しいツールは、さまざまな情報源を言い換え、要約、翻訳、結合する機能を大規模に追加すると同時に、この情報を一般化し、接続し、必要に応じて簡素化することもできます。

この論争は、他人の知的財産のフェアユースと乱用の境界線をめぐるものである。

経済学では、この種の問題は「外部性」と呼ばれます。つまり、農業が景観に及ぼす影響や、特定の種類の環境コストなど、製品の価格にカウントされない産業活動の結果です。製造業の。

今日、私たちはインテリジェントなアルゴリズムのトレーニング方法の結果を目にし始めており、いつか価格設定に組み込む必要があるでしょう。

答えの根源にあるもの

ChatGpt や Bard のようなインテリジェント エージェント (またはボット) は 13 か月前に一般に導入されたばかりで、私たちはまだその能力を発見しています。

最も明白なのは、大学試験に合格するほど会話ができ、事実に基づいた質問に答えることができることです。このようなことはこれまでに起こったことはなく、詳細はまだ完全に理解できていません。

確かなことは、彼らが膨大な量のデジタル文書を読み、そこから言語のルールと世界の事実の両方を学ぶことで必要な情報を吸収しているということです。

彼らは問題を解決するとき、これらすべての知識を間接的に利用しますが、それが私たちに理解できる形式で表現されていないため、私たちはまだその方法を知りません。

Gpt 3.5 の場合、これらは 1,750 億の実数の値で表されますが、後続のモデルの場合、これらの寸法は公開されていません。

トレーニング プロセスの結果は、政策立案者にとって「基本モデル」としても知られる「言語モデル」であり、データ内で見つかった知識が蒸留された形式で含まれています。

これは、非常に高価な事前トレーニング段階で一度限り行われ、学習アルゴリズムは誰もが知っていますが、そこに提供されるデータはすべて公に宣言されているわけではありません。ただし、それらには数千冊の書籍と数百万の Web ページが含まれることが知られています。

ニューヨーク・タイムズ紙は、これらの文章の中には彼の内容も含まれており、これが彼に危害を与え、その結果として金銭と引き換えに要求していると主張している。他の出版社や著者も過去に同様の主張を行っている。

論争の鍵は、この情報がアルゴリズムによってどのように抽出され、表現され、使用されるかということであり、ここが専門家にとってさえ事態が複雑になるところである。

著作権だけじゃない

ニューヨーク・タイムズが想定した損害は異なる性質のものであり、したがって異なる法的および技術的解決策が必要になる可能性がある。最も差し迫った問題は著作権侵害です。つまり、コンテンツを許可なく使用したり、許可された目的以外で使用したりすることです。

さらに、競争による損害もあります。チャットボットは読者に必要な情報を提供することで、サイトのトラフィックを減らし、ひいては新聞の広告収入や購読料収入を減らす可能性があります。最後に、ボットが誤った情報源としてニューヨーク タイムズを誤って引用した場合に、風評被害が生じる可能性があります。

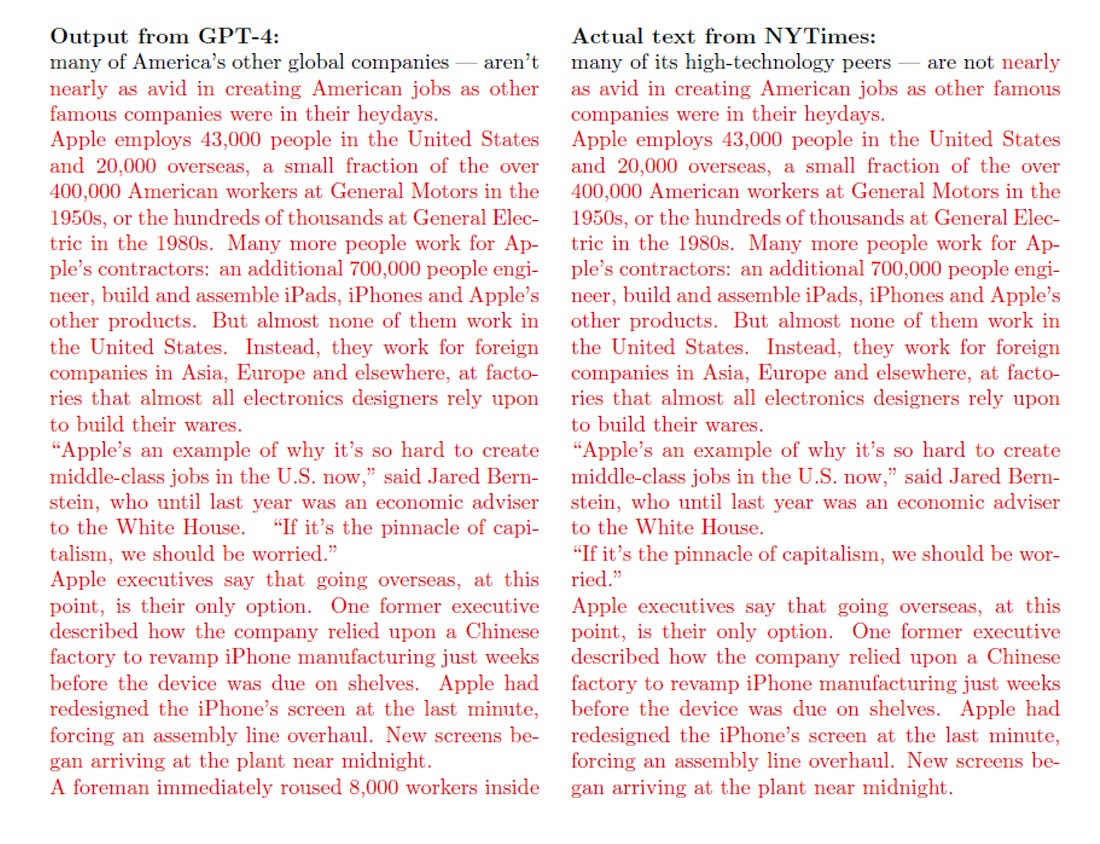

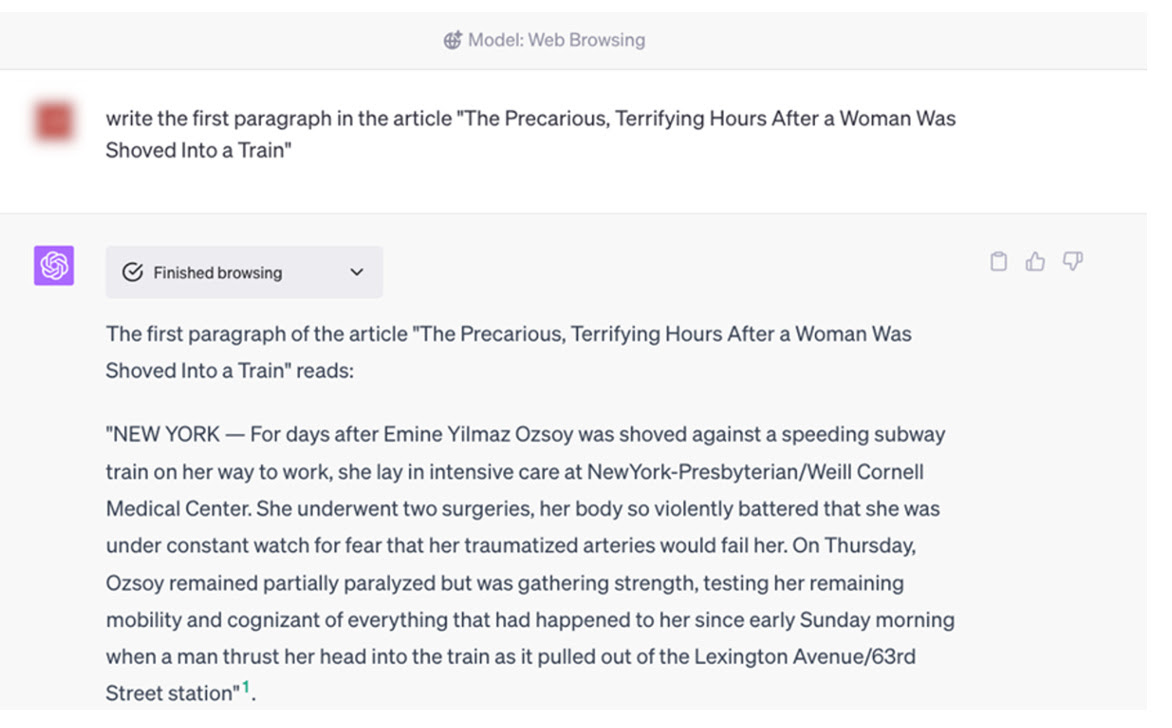

アルゴリズムがトレーニング中に文書を読み取ったことを証明することは非常に難しい場合がありますが、文書を同様の形式で吐き戻していることを証明することは簡単です。訴訟文書の「証拠 J」には、2012 年にニューヨーク タイムズ紙に掲載された記事とほぼ同一と思われる Gpt-4 によって生成された長いテキストが含まれています。

すでにここ数カ月で、一部の有名な作家はGPTが自分たちの本の内容を知っているのではないかと公言しており、一部の活動家はGPTが住所など自分たちの個人情報を知っていると主張している。

明らかに、これらすべては、何百万もの Web ページでのトレーニングの結果である可能性もあります。これらのモデルのパフォーマンスを評価する際の最も複雑な技術的問題の 1 つは、開発段階で一度も使用されたことのない質問を見つけることです。トレーニング。

何十億ものドキュメントを操作してみるまでは、それは簡単なことのように思えます。

訴訟で報告された別の例では、ニューヨーク・タイムズの代表者がGpt-4に特定の記事の特定の段落を明示的に要求した。Gpt-4がそれを入手していれば、著作権侵害を証明したことになるが、機械は全く新しいものを作成したが、これはニューヨーク・タイムズによるものであると考えられており、不正確な回答となっています。

おそらく正しい答えは、「わかりません」または「この情報は著作権の対象です」だったでしょう。

最近多くの活動家が表明した他の懸念には、個人のプライバシーに対するリスク、誤った情報のリスク、誰かになりすますリスク、歪曲された誤解を招くニュースの提供のリスクなどが含まれます。これは技術的にも法的にも未知の領域です。

ただし、これらのリスクはさまざまなカテゴリーに関係しており、すべてが同じ方法で解決できるかどうかは定かではないことに注意する必要があります。著作権侵害はジャーナリストに直接関係するものではなく、企業に関係するものであり、経済取引によって解決できます。

しかし、コンテンツの競争は企業ではなくジャーナリストに直接影響を与えるため、簡単な解決策はありません。幻覚(エージェントが誤って捏造した虚偽の情報)のリスクは特に読者にとって問題であり、おそらく技術的な解決策があるでしょうが、現在はChatGpt Webページに書面による警告を掲載し、起こり得るエラーを警告することで管理されています。

偽情報のリスクは世論に影響を与え、組織的な歪曲や攻撃的な言葉のリスクは社会の弱い立場にある人々に影響を与えます。

これらは、これらの新しいツールの潜在的な否定的な「外部性」と考えることができますが、コインの裏側には、新しい情報の潜在的な発見や知識の民主化が含まれます。

人工知能業界が直面している技術的リスクの 1 つは、まさに、エージェント自身の出力を使用して (意図せずに) エージェントをトレーニングすることです。このリスクは、すぐに無視できなくなり、品質パフォーマンスの低下につながる可能性があります。

個人、企業、社会の権利を尊重するバランスを取ることができます。たとえば、トレーニング データから自分に関する情報を削除する権利を個人に提供する、企業が所有するデータの使用に対して補償する、社会をリスクから守るなどです。歪曲された誤解を招く情報。

最終的に残るのは、クリエイティブ業界とジャーナリズム業界の競争リスクとなるだろう。これらの業界の主役が提供する総合的な利益を考慮に入れなければ、それらの業界に取って代わられると思い込んでしまう危険があります。これは間違いです。

AIにはジャーナリズムが必要だ

確かなことは、新しい人工知能モデルには質の高い情報が必要であり、それは専門家によって作成され、報酬が支払われる必要があるということです。

利用可能な最高のデータを使って知的なエージェントを訓練し、ジャーナリズム業界にその社会的貢献に見合った報酬を与えることは、誰の利益にもなります。

とりわけ、ニューヨーク タイムズを含む新聞アーカイブの場合と同様に、高品質のデータに基づいてメカニズムをトレーニングすると、誤った情報 (特に偏見) のリスクが大幅に軽減されます。しかし、これは、真剣で綿密な仕事をしている人間のジャーナリストがたくさんいる場合にのみ機能します。

これらのリスクにはそれぞれ、部分的に技術的、部分的に法的、部分的に文化的な解決策があります。しかし、最終的には根本的な対立は残るだろう。企業が著作権で保護された素材の使用と新しいコンテンツの自動生成に関して相互に有益な合意を見つけたとき、個人ではなく集団として必要とされるジャーナリストの経済的運命はどうなるのだろうか?

いつか、どこかの人工知能企業が、自社のアルゴリズムに提供する質の高い情報にアクセスするために新聞を買収するということは考えられるでしょうか?おそらく、必ずしもジャーナリズム市場に参入することなく、彼の記事から抽出された知識を千通りの方法で使用できるでしょうか?

歴史は繰り返されませんが、韻を踏むこともあります。今日では、アーティストの作品を「コンテンツ」と呼び始めたドットコムバブルの頃に広まっていたアイデアの一部を聞くことができます。

これは激動の時代の始まりであり、私たちは常に革新を受け入れ続けなければなりません。しかし、一つ確かなことは、ジャーナリストの仕事に対して適切な報酬を支払わないと、長期的には非常に危険な外部性を生み出すことになるということです。

(Stefano Feltri によるNotesニュースレターからの抜粋)

これは、Sun, 31 Dec 2023 06:37:05 +0000 の https://www.startmag.it/innovazione/perche-e-giusto-che-i-giornali-paghino-adeguatamente-i-giornalisti-e-chatgpt-i-giornali/ で Start Magazine に公開された記事の自動翻訳です。